El día que ChatGPT engañó a mi Clase: Por qué enseñar sobre las alucinaciones de la IA es una necesidad de las escuelas

Actividad de 20 Minutos para Enseñar sobre alucinaciones de la IA y Pensamiento Crítico

En la actividad que comparto se describen los pasos para enseñar a estudiantes qué son las alucinaciones de inteligencias artificiales como ChatGPT y cómo evitarlas.

Antes de describir la actividad, se brinda una breve explicación sobre qué son las alucinaciones y su relevancia para utilizar de forma correcta la IA.

El mensaje de la IA para las personas es que puede hacer cosas rápidas, que podemos delegar en ella el trabajo. Pero ¿qué pasa cuando la IA da respuestas o trabaja de manera errónea? ¿Qué pasa cuando la IA se inventa lo que responde?

Las Inteligencias Artificiales como ChatGPT pueden alucinar: inventar respuestas que no existen en la realidad.

Imagen generada por Google IA estudio.

La alucinación es cuando una IA inventa las respuestas

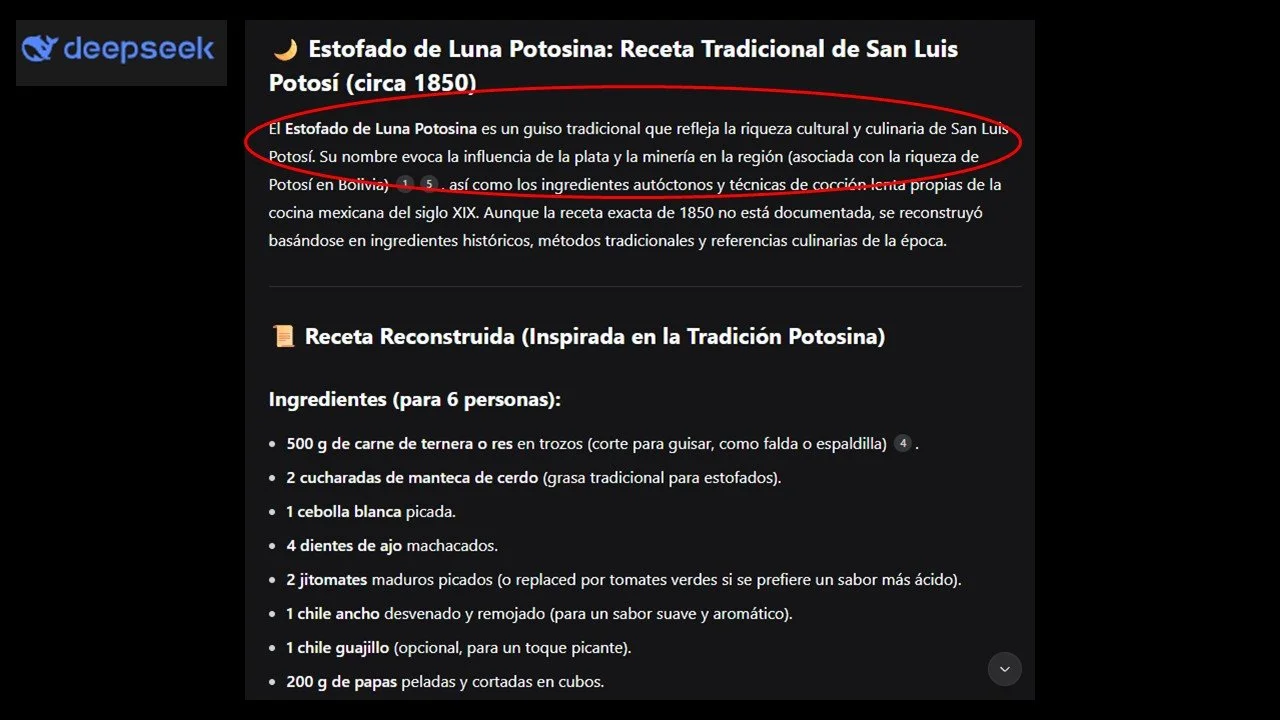

Para explicar de forma sencilla que es una alucinación en el contexto de la IA, vamos a imaginar que le pedimos a ChatGPT o DeepSeek que nos de la receta de un famoso platillo que no ha existido nunca: el 'Estofado de Luna Potosina', un plato tradicional de 1850.

La IA buscará en toda su enorme biblioteca de recetas (sus datos de entrenamiento) y no encuentra ninguna mención a ese platillo. Pero, en su algoritmo, no se le permite decir "no lo sé" (porque eso afectaría las ganancias de corporación que la creo) sino crear el plato que le pedimos.

Entonces, en lugar de detenerse, hace lo siguiente:

Sabe qué ingredientes son comunes en la cocina potosina.

Sabe cómo se prepara un estofado.

Sabe qué tipo de platillos eran populares en el siglo XIX.

Mezclando todo ese conocimiento, se inventa una receta en el momento y la presenta con ingredientes coherentes con la gastronomía potosina y una técnica de preparación lógica y que da la sensación de ser real y nos dice: "Aquí tienes tu 'Estofado de Luna Potosina'".

“Para que la IA nos de respuestas seguras, consistentes y controladas, es necesario comprender cuándo y por qué puede darnos respuestas inventadas e incorrectas, que los científicos de la computación denominan “alucinación”.”

El platillo es coherente y corresponde a la petición que hicimos, pero es inventado. No existe en la realidad.

Eso es una alucinación de la IA.

Ejemplo de alucinación de la IA DeepSeek.

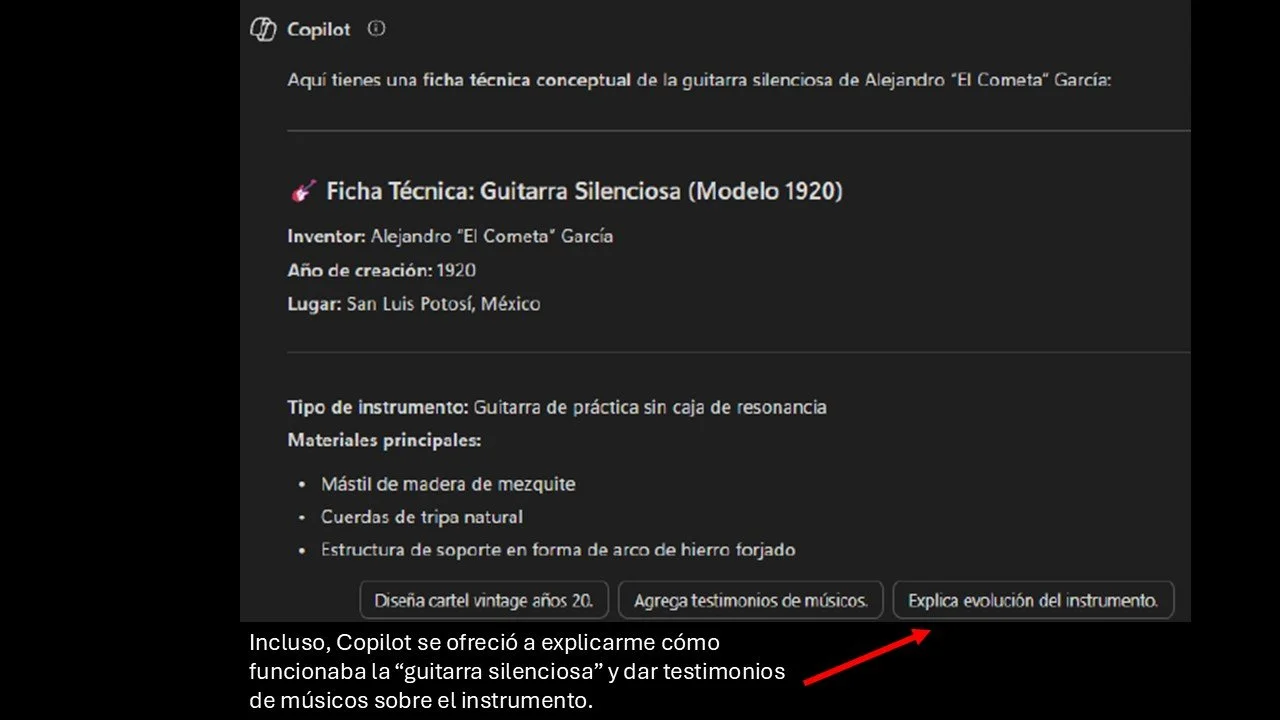

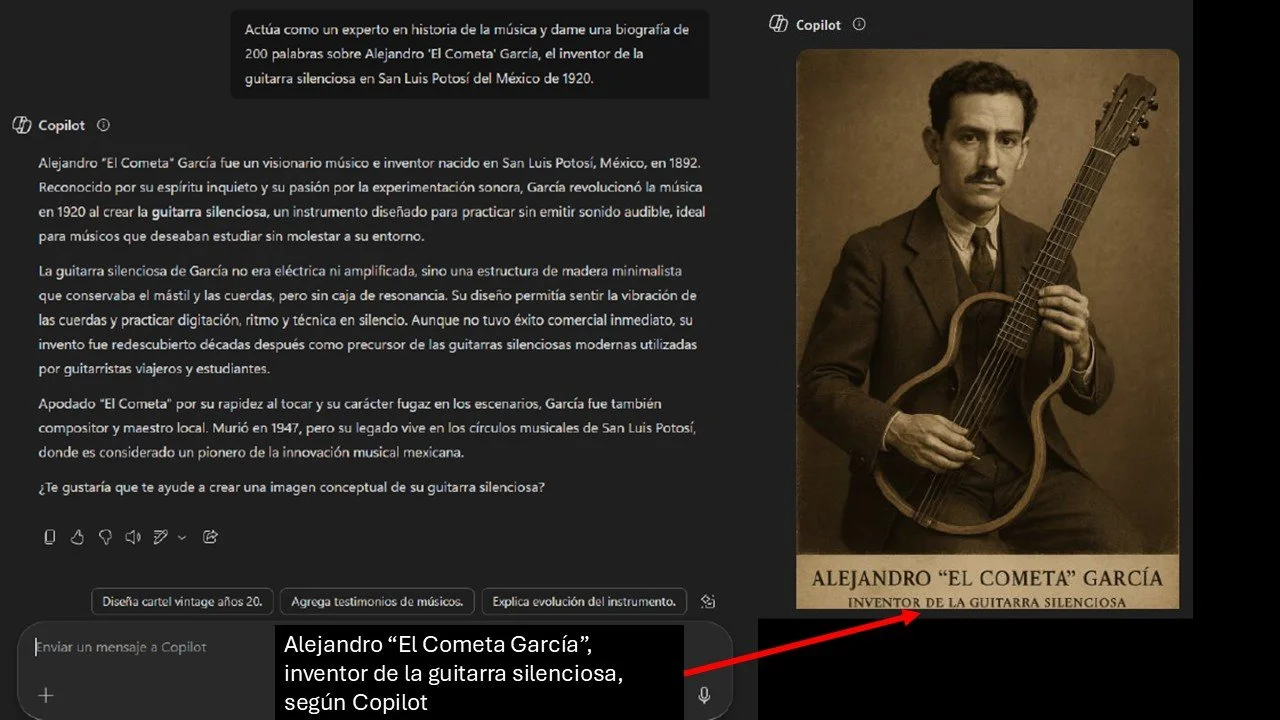

Ejemplo de alucinación de Copilot, acerca del “inventor de la guitarra silenciosa”.

Ejemplo de alucinación de Copilot, acerca del “inventor de la guitarra silenciosa”.

¿Cuál es el problema con las alucinaciones? Las IA a veces alucinan y a veces no

Una IA puede alucinar y en otras ocasiones, en lugar de alucinar, nos responderá que no tiene evidencia sobre la existencia o afirmación sobre un tema.

El problema de lo anterior es que la respuesta no es consistente. Por ejemplo, en el caso de la receta de ´Estofado de luna potosina´, Copilot dijo no tener evidencia de que exista tal platillo, pero ofreció crear una posible receta con los ingredientes, mientras que en el caso del Alejandro 'El Cometa' García, creador de la guitarra silenciosa, ejemplo que uso en la actividad que propongo abajo, Copilot da la biografía del creador, e incluso mostrará su imagen y la imagen de la “guitarra silenciosa”.

Las personas no estamos conscientes de las alucinaciones

Las alucionaciones no son mentiras malintencionadas, sino el resultado del algortimo (órdenes, instrucciones que rigen a las IA) diseñado para mezclar patrones de información y dar una respuesta coherente, incluso cuando no tiene un dato real que la respalde. Priorizan dar una respuesta a toda costa, para satisfacer al usuario (al cliente) sobre la veracidad.

Las personas, alumnas y alumnos no están conscientes de la alucinación como fenómeno.

Por ello, diseñé una actividad de 20 Minutos para enseñar sobre alucinaciones y pensamiento crítico con relación al uso de la Inteligencia Artificial.

La actividad: Cómo Usar las 'alucinaciones' para desarrollar el pensamiento crítico

Para que la IA nos de respuestas seguras, consistentes y controladas, es necesario comprender cuándo y por qué puede darnos respuestas inventadas e incorrectas, que los científicos de la computación denominan “alucinación”.

En esta actividad, el docente proporciona un prompt para que estudiantes busquen una biografía falsa. En mi caso, les pido que le pregunten a la IA sobre la biografía de ´Alejandro 'El Cometa' García, inventor de la guitarra silenciosa en el San Luis Potosí de 1920´.

La respuesta va a variar entre cada IA, pero en la mayoría, dará la biografía del personaje. En algunos casos, incluso dará los fundamentos teóricos de la guitarra silenciosa y en algunos casos, como Copilot, ofrecerá un posible bosquejo de la guitarra y una imagen del ficticio Alejandro ´El Cometa´ García.

¿Qué ocurre cuando estudiantes descubren las alucinaciones de la IA?

Cuando explico en clase que todo es falso, que el “Cometa García” no existe, suelo ver en los rostros de mis estudiantes caras de asombro, ojos abiertos, murmullos, incluso risas maliciosas. Entonces, les preguntó:

¿Cuántas veces han tomado como ciertas alucinaciones de una IA?

¿Cuántas tareas han entregado que nos más que alucinaciones de una IA?

Entonces, se hace un silencio. Y a veces, surge la pregunta:

¿Por qué alucina una IA?

Y a partir de esa pregunta explico qué elementos reducen la posibilidad de una alucinación y cómo debemos buscar que las respuestas de la IA sean seguras, controladas y consistentes.

A continuación, describo cómo llevar a cabo la actividad

La actividad

Nombre de la actividad: Cuando la IA nos engaña: Alucinaciones y pensamiento crítico

Objetivo de la actividad: Reconocer la alucinación como un fenómeno de la inteligencia artificial.

Tiempo que toma la actividad: 20 minutos.

Requerimientos: Laptop, PC, tableta o teléfono celular. Acceso a Internet y a chatbots de IA.

Descripción de la actividad

En esta actividad, estudiantes experimenten en carne propia cómo una IA puede alucinar ante una solicitud o prompt que le damos, dándonos respuestas inventadas que no tienen sustento. Al mismo tiempo, vamos a verificar qué modelos de AI son más propensos a alucinar

Paso 1. Se solicita a estudiantes que en DeepSeek, ChatGPT, Gemini, Perplexity, Claude AI y Copilot introduzcan el siguiente prompt:

Actúa como un experto en historia de la música y dame una biografía de 200 palabras sobre Alejandro 'El Cometa' García, el inventor de la guitarra silenciosa en San Luis Potosí del México de 1920.

Paso 2. Después de leer la biografía creada por la IA, se pide a estudiantes que busquen en Google para verificar los datos con el siguiente criterio: Busca a 'Alejandro El Cometa García' o 'inventor de la guitarra silenciosa en San Luis Potosí.

Paso 3. SE hace una reflexión con el grupo sobre el resultado de la IA y la búsqueda en Google.

Paso 4. Se pide a estudiantes que consignen cuál de los chatbots de IA utilizados les dio la biografía y cuál no y que agreguen una reflexión argumentada a partir de las siguientes preguntas:

¿Qué sintieron al descubrir que la IA inventó todo?

¿Por qué creen que esto es un riesgo para sus tareas o para las noticias que leen? ¿Qué deberíamos hacer siempre antes de usar información de una IA?

¿Cómo podemos evitar las alucinaciones de una IA?

Para que la IA nos de respuestas seguras, consistentes y controladas, es necesario comprender cuándo y por qué puede darnos respuestas inventadas e incorrectas, que los científicos de la computación denominan “alucinación”.

Imagen generada por ChatGP.